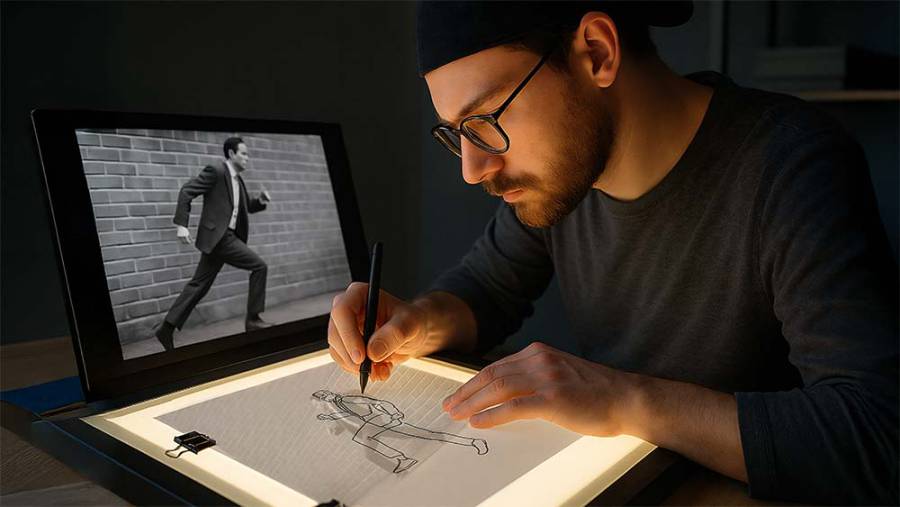

Segen und Schwächen der Künstlichen Intelligenz (KI) werden nun, wo sich so viele damit beschäftigen, immer deutlicher. Während man die Vorteile gerne in den Vordergrund stellt, sie sind in manchen Bereichen wirklich beeindruckend, wird über die Schwächen wenig gesprochen. In der Bildbearbeitung fallen ab und zu übersehene Fehler auf, etwa wenn Personen in manipulierten Bildern plötzlich zu viele Hände aufweisen. Da es keinen Rückkanal gibt, um ide KI auf diesen Fehler hinzuweisen, wird sie es wieder tun. Es ist sogar noch schlimmer, die KI lernt aus ihren Bildern und verringert auf der Suche nach massenhafter Bestätigung, die Anzahl der Variationen und auch deren Detailgenauigkeit. Das Lernen an den eigenen Bildergebnissen verschlechtert so nach und nach die Ergebnisse.

Darunter leiden Programme wie Adobes "Firefly", "Photoshop" aber auch der KI-Bildgenerator "Midjourney". Die Bildgenerierungen und Bildmanipulationen sind oft so perfekt, dass man schon lange suchen muss um auffällige kleine Bildstörungen zu erkennen. Schwierigkeiten haben die Bildprogramme häufig mit Fingern und Zehen, sie werden oft in falscher Anzahl dargestellt oder sehen merkwürdig aus. Manchmal trifft man auch auf Ansätze, welche verhindern sollen, dass die KI im Auftrag der User Unsinn produziert, der dann wieder in Lernschleifen der KI eingefügt werden könnte. Bis zu einem gewissen Grad haben die Programmanbieter auch Grenzen eingebaut, dann gibt beispielsweise Firefly eine Warnmeldung aus, dass "bestimmte Wörter nicht den Nutzungsrichtlinien entsprächen und entfernt wurden".

Interessant ist auch, dass die Ergebnisse beim Generieren von Personen bereits jetzt bestimmte Festlegungen in sich tragen, welche nicht die Realität unserer Welt wiederspiegeln. So erzeugt die Eingabe des Prompts "Frau" stets Abbilder junger Frauen, während bei "Mann" von Jung bis Alt, die gesamte Altersbandbreite unter den Vorschlägen zu finden ist. Ob dies durch Fehler der KI oder durch die verschobenen, von Männern dominierten, Gewichtungen der Bilderwelten im Internet verursacht wird, lässt sich allerdings schwer nachvollziehen.

Texte in der KI

Bei Texten gibt es einen signifikanten Anteil, wo die Künstliche Intelligenz schlichten Unsinn in bestens formulierten Sätzen abliefert. Die Formulierungen der Antworten ähneln sich allerdings immer mehr und erinnern manchmal an die "Radio Eriwan"- Witze aus den 70er Jahren des letzten Jahrhunderts. Diese fiktiven Zuhörerfragen an den fiktiven kommunistischen Radiosender Eriwan drehten sich zumeist selbstironisch um die Schwächen der damaligen Sowjetunion. Praktisch jede Antwort begann mit der Formulierung "Im Prinzip ja, aber..." Und so ähnlich fühlen sich auch die meisten Antworten von Chat GPT & Co an. Einleitung, positive Aspekte, negative Aspekte, Fazit.

Warum sie in diesen Fällen Blödsinn als Antwort produzieren, lässt sich zumindest für die Anwender, nicht nachvollziehen und die Anbieter der KI haben keine Zeit und Möglichkeit, den Individualfall zu überprüfen. Längst sprechen Anwender von KI-Halluzinationen, wenn KI Modelle (LLM) wie ChatGPT oder Mistral AI Antworten geben, die frei erfunden, ja genial erlogen sind. Das kann bis zu völlig verschobenen historischen Ereignissen, verdrehten Fakten und falschen Zitaten reichen. Die dahinter stehenden Sprachmodelle sind zumeist Firmengeheimnis und bleiben den Anwender vollständig verborgen. Als naheliegenste Ursache wird häufig die schlechte Datenqualität und Methodik des Trainings vermutet, weil ungeprüft unvollständige oder sich widersprechende Informationen eingelesen werden. Fatalerweise informiert uns die KI auch nicht darüber, wie hoch die Wahrscheinlichkeit ist, dass die Anwort auch korrekt ist. Es gibt keine Bewertung, etwa dass die Wahrscheinlichkeit einer richtigen Antwort bei 80% liegt. Stattdessen präsentiert uns die KI ihre Ergebnisse mit 100% Autorität. Menschen würden in vielen Fällen zugeben, dass sie eine Antwort nur erraten oder vermutet haben,- doch die KI macht ein souveränes Pokerface. Wie gehen wir damit um, wenn wir die KI beim Drehbuchschreiben oder der journalistischen Recherche etwa für einen Dokumentarfilm einsetzen?

Wierdo?

Die Häufigkeit der Fehler ist inzwischen auch Forschungsgegenstand und man hat diese bereits konkret benannt, es handelt sich um "Model Autophagy Disorder", die man sinnigerweise mit "MAD" abkürzt. Diese hat nämlich sehr viel damit zu tun, dass die KI selbstlernend ist und sich mit den selbst generierten fehlerhaften Lösungen trainiert. Sie lernt also von den falschen Inhalten. Das Training anhand von selbst erzeugten falschen Daten kann im schlimmsten Fall ganze KI Systeme zerlegen. Das Problem hängt damit zusammen, dass die KI grundsätzlich Inhalte aus mehrheitlich gefundenen Aussagen generiert und nicht aus seltenen Quellen des Internets. Kritische Meinungen oder andere Darstellungen, die weniger häufig im Internet vorkommen, werden ausgelassen. Wenn nun die selbst erzeugten Inhalte hinzu kommen, erhöht dies die Anzahl der mehrheitlichen Aussagen.

Wenn nun bestimmte Informationen falsch sind und die KI generiert daraus eine falsche Antwort, so erhöht diese von der KI erzeugte falsche Antwort automatisch die Anzahl aller falschen Antworten. Die KI bestätigt also ihre eigenen Fehler selbst mit jeder Anfrage die zu diesem Thema gestellt wird. Jede falsche Antwort führt also dazu, dass diese von der KI als richtig betrachtet wird. Man kann das ganz gut bei den Antworten der gängigen KI Systeme wie CHatGPT erkennen. Bestimmte Formulierungen und Satzbausteine werden nach und nach häufiger verwendet, als in der Anfangszeit von ChatGPT. Viele User schenken den KI Modellen viel Vertrauen und betrachten sie als Autorität, auch weil für sie kaum bis gar nicht erkennbar ist, ob die angebotenen Informationen wahr sind oder frei erfunden. Da viele Menschen bereits jetzt Textergebnisse der KI kritiklos per Copy & Paste übernehmen, kann sich das langfristig tatsächlich auf unsere Sprache auswirken. Das Risiko besteht, das der Reichtum der Sprache, das die Vielfältigkeit und inhaltlich auch die Vielfalt an Gedanken und Haltungen auf der Strecke bleibt.

Folgen

Das bedeutet, dass die Bandbreite der Antworten oder die Informationsbreite der KI kontinuierlich abnimmt. Je stärker eine KI also von selbst erzeugten Daten lernt, desto mehr wird sie von "MAD" betroffen sein und damit schlechtere Ergebnisse produzieren. Fatalerweise erkennt die KI selbst häufig nicht, welche Inhalte von Menschen und welche von KI generiert wurden. Ein fataler Teufelskreis, den die Anbieter von KI-Modellen dringend durchbrechen müssen. Denn wenn man die KI so weiterlaufen lässt, wird sie immer weiter in dieses Dilemma hineinrutschen, sie kann sich nicht von allein aus dieser fatalen Schleife herausretten. Hier ist der Mensch gefragt und zwar schnell. Und es bedarf mehr Wissensvermittlung im Bereich Medienkompetenz und Digital Literacy. Bis dahin hilft nur ein gesundes Maß an Kritik und möglichst genaues Formulieren der Anfragen (Prompten) mit viel Kontext und Zusatzinformation wie möglich.